引言:换代通知书

这不仅仅是一份文档,它是谷歌向开发者和企业发出的"换代通知书"。

如果说2023年是LLM(大语言模型)的爆发年,那么2024-2025年则是Agent(智能体)的落地元年。谷歌近期发布的这46页《AI Agent Handbook》,彻底终结了"Prompt Engineering就能搞定一切"的幻想,将AI应用开发正式推入了"系统工程时代"。

一、范式转移:从"对话框"到"数字员工"

过去,我们把AI当作一个"会说话的百科全书"。你问,它答。这种模式的上限在于:它无法走出对话框去干活。

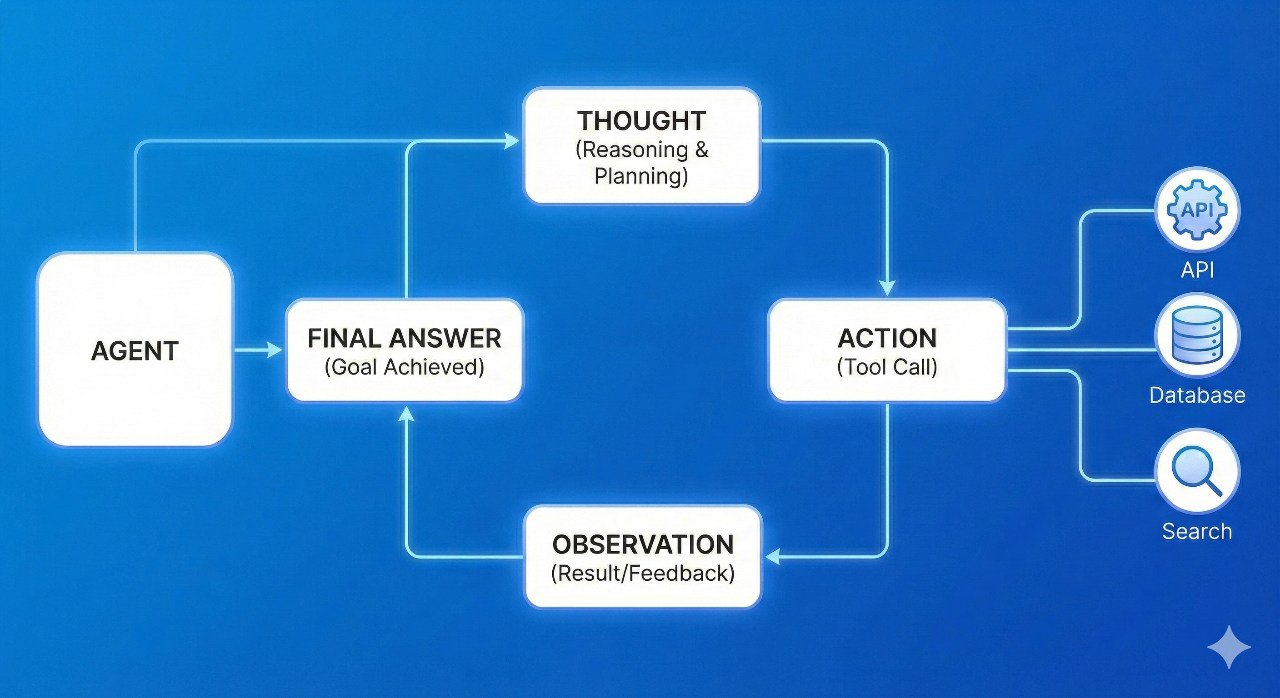

谷歌在手册中明确了Agent的定义:Agent = LLM + 规划 + 记忆 + 工具使用。

- 传统LLM:是一个预测下一个Token的概率模型。

- AI Agent:是一个能够自主理解目标、拆解步骤、调用外部API、观察执行结果并自我修正的闭环系统。

这种转变意味着,AI不再只是给你写个周报草案,而是能直接登录你的CRM系统,调取客户数据,分析流失原因,并自动起草并发送挽留邮件。

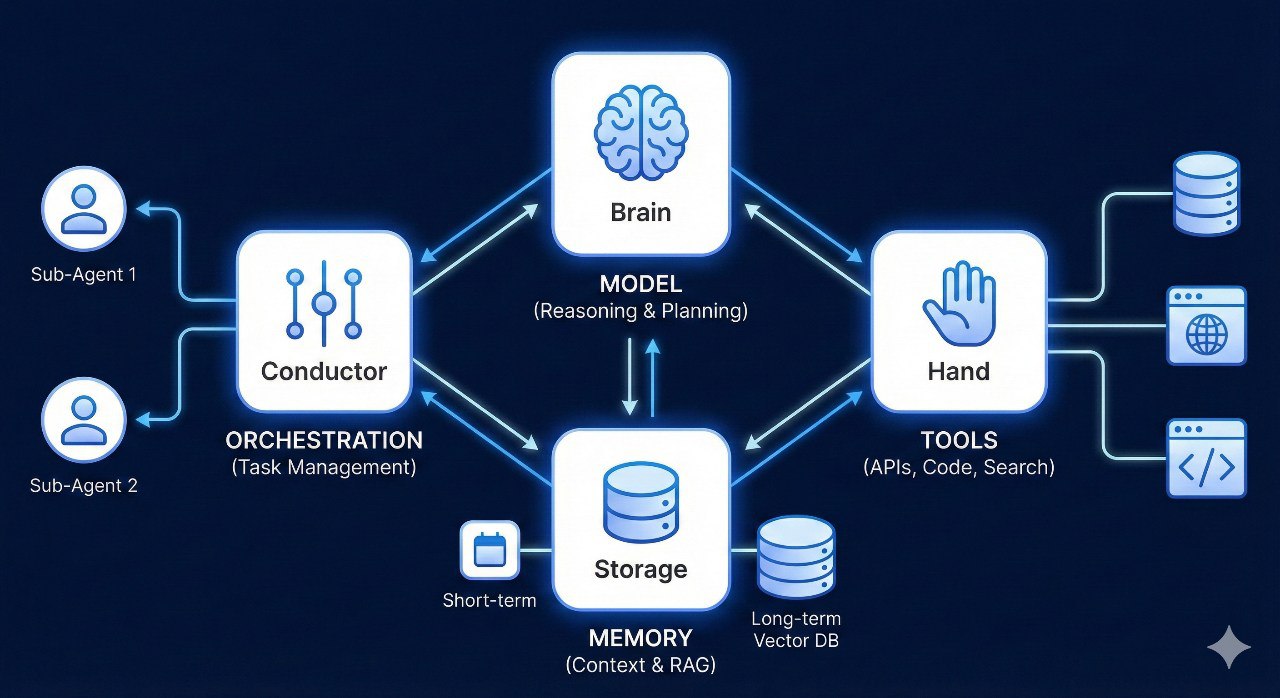

二、核心架构:构建Agent的"四大支柱"

谷歌将一个生产级Agent的架构拆解为四个互联的模块。理解了这四点,你就掌握了Agent的骨架。

1. 大脑:模型与推理能力

大脑负责逻辑判断。手册强调,Agent的成败不在于模型有多大,而在于其"推理轨迹"(Reasoning Trajectory)。谷歌推荐使用ReAct框架,其逻辑公式为:

1 | Agent必须在每一步行动前先"思考",行动后观察结果,再决定下一步。 |

2. 工具:Agent的"手"

没有工具的Agent只是空谈家。手册重点讨论了MCP(Model Context Protocol)协议。通过标准化接口,Agent可以调用:

- 搜索工具:获取实时信息。

- 代码解释器:进行复杂的数学计算或数据可视化。

- 自定义API:读写数据库、操作第三方SaaS软件(如Slack, GitHub)。

3. 记忆:上下文的持久化

Agent需要记得"自己是谁"和"之前干了什么"。

- 短期记忆:依靠模型的上下文窗口(Context Window)。

- 长期记忆:依靠RAG(检索增强生成)和向量数据库。谷歌指出,高效的Agent应该能从海量历史操作中检索出类似的"成功案例"来指导当前任务。

4. 编排:复杂任务的指挥部

这是最体现"企业级方法论"的地方。对于复杂任务,单个Agent会崩溃。谷歌提出了"多代理编排"(Multi-Agent Orchestration)。

| 模式 | 描述 | 适用场景 |

|---|---|---|

| 单代理 (Single Agent) | 一个模型包揽所有。 | 简单、线性的自动化任务。 |

| 主从模式 (Leader-Worker) | 一个主Agent拆解任务,分发给子Agent。 | 软件开发、内容分发流水线。 |

| 交接模式 (Handoff) | 类似客服转接,A解决不了转给B。 | 复杂的客户支持系统。 |

三、避坑指南:为什么你的Agent总是"胡言乱语"?

谷歌在手册中用大量篇幅讨论了"幻觉"与"失控"。在生产环境下,Agent的不确定性是致命的。

1. 轨迹偏离 (Trajectory Drift)

Agent在执行长序列任务时,往往会因为中间某一步的微小错误,导致后续步骤完全跑偏。

- 对策:引入"反思机制"(Self-Reflection)。在关键节点强制Agent进行自我审查:“我现在的进度是否符合最初的目标?”

2. 工具调用的确定性

如果Agent乱传API参数,系统就会报错。

- 对策:谷歌建议使用Few-shot Prompting(少样本提示),给Agent展示3-5个正确的API调用范例,而不是只给一个文档。

四、AgentOps:像管理软件一样管理AI

这是这份手册最具前瞻性的部分。谷歌认为,Agent的开发已经从"写代码"变成了"养员工",因此需要一套全新的运维体系——AgentOps。

测评的三个维度:

- 输入评估:Prompt是否清晰?上下文是否冗余?

- 过程评估(轨迹检查):这是最关键的。不仅看结果对不对,还要看Agent的思考过程是否符合逻辑。

- 输出评估:使用"模型评测模型"(LLM-as-a-judge),让一个更高级的模型(如Gemini 1.5 Pro)给子Agent的表现打分。

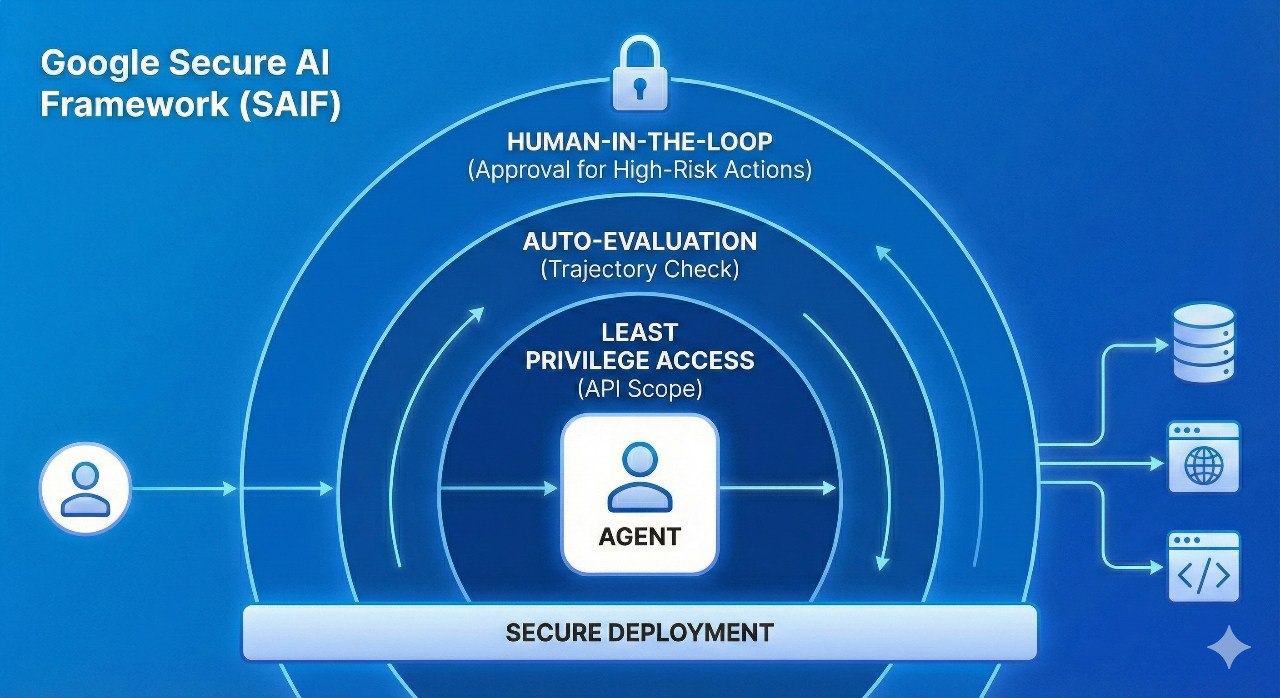

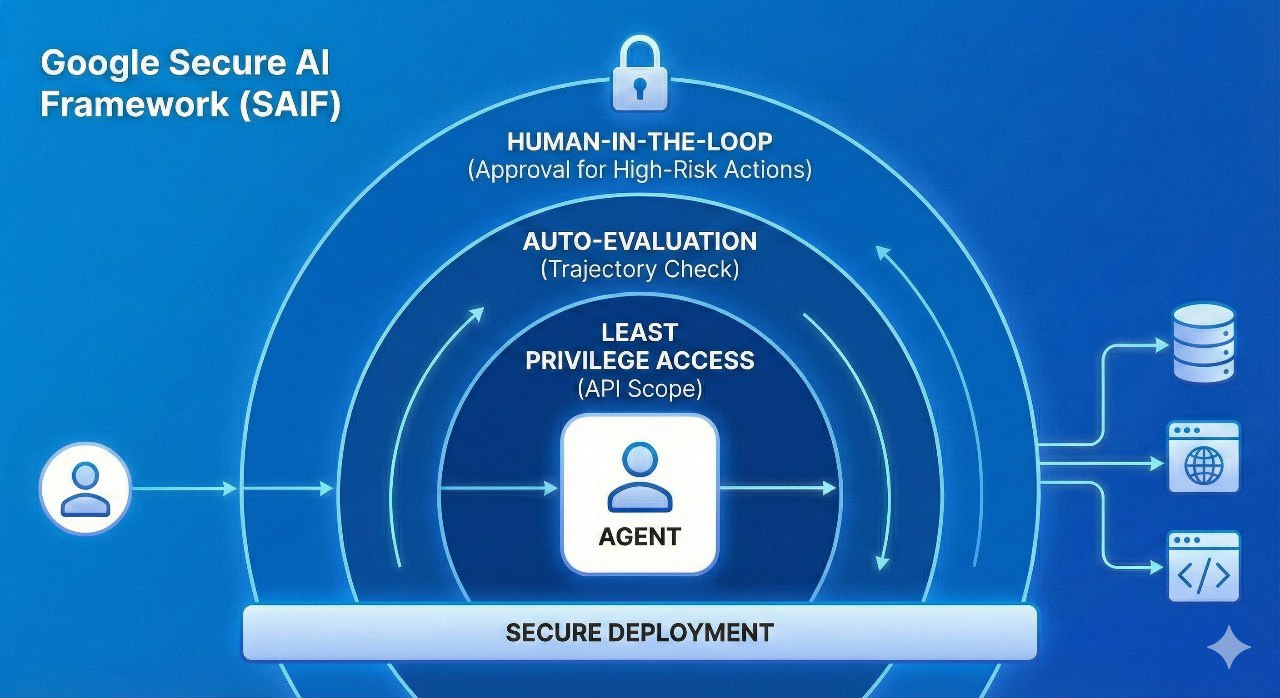

安全防线:SAIF框架

当Agent拥有了操作数据库和发送邮件的权限,安全风险指数级增加。谷歌提出的SAIF (Secure AI Framework)要求:

- 权限最小化:Agent只能访问任务必需的API。

- 人机协同 (Human-in-the-loop):在执行"删除"或"支付"等高风险操作前,必须通过人类确认。

五、实战建议:如何开始你的Agent之路?

如果你打算按照谷歌的方法论构建自己的Agent,请遵循以下路径:

- 寻找"高价值且容错性高"的场景:比如内部知识库问答、自动化周报生成。不要一开始就让AI直接对接终端客户。

- 从小开始:先做一个能精准调用1个工具的Agent,而不是一个能干10件事的半成品。

- 重视数据治理:Agent的上限取决于它能获取的数据质量。如果你的企业文档一团糟,RAG出来的记忆也必然是垃圾。

- 关注"确定性":宁可让Agent在不确定时停下来提问,也不要让它在错误路径上狂奔。

结语:系统工程的胜利

谷歌这份手册的核心思想可以浓缩为一句话:Agent不是奇迹,而是精心设计的系统。

告别对"神奇提示词"的迷信,转而关注架构设计、内存管理、工具链优化和持续监控。这才是通往真正AI生产力的唯一路径。

参考资料:

- Google《AI Agent Handbook》,2025年

- ReAct框架论文,2022年

- MCP(Model Context Protocol)官方文档

- SAIF(Secure AI Framework)安全框架

作者: 工业智能算网

发布时间: 2026年2月13日

分类: AI技术 / 企业数字化转型

标签: AI代理, 谷歌, 数字员工, AgentOps, 大模型, 系统工程, 自动化